服務器系統對RISC架構的追求正在加強。

許多人等了好幾年才聽到像 Meta 高級工程總監 Prahlad Venkatapuram這樣的人說出本周在 RISC-V峰會上發表的內容:

“我們已經確定,RISC-V是我們前進道路上所有產品前進的方向。這不僅包括下一代視頻轉碼器,還包括下一代推理加速器和訓練芯片。”

他解釋說,在過去4年中,他們不僅推出了硬件,而且還通過標準化的基于 RISC 的控制系統為未來的定制 RISC-V 芯片奠定了基礎,并使其具有可擴展性,因此,Meta 為所有領域開發的任何 IP 都將適應并輕松連接到 NOC。

換句話說,Meta 有一個模板可以快速將任何此類新芯片投入生產,這對于那些尋求大規模 RISC-V 成功案例的人來說是一件大事。所有這一切都是在高端 GPU供不應求的時候進行的,而且價格也有所反映。

Venkatapuram 表示,Meta 之所以選擇 RISC,是因為需要加速所有“我們在 CPU上無法完成的關鍵業務”,以及“服務器上的能效、性能和絕對低延遲”。他補充說,支持不同工作負載的靈活性和架構中的彈性也至關重要。

“無論何時我們設計或部署,都希望它能夠存在 3-4 年,因此,必須具有彈性和可編程性——我們希望讓軟件負責我們如何使用硬件資源。”

他補充說,64 位尋址至關重要,內核中的矢量和 SIMD 功能也是必不可少的,并強調了深度定制的必要性。“很明顯,RISC-V可以做所有這些事情;它是開放的,有強大的支持,有多個知識產權提供商,以及我們在過去 4-5 年中看到的不斷發展的生態系統。但歸根結底,定制是關鍵。”

僅基于 RISC-V 構建的視頻轉碼硬件 Meta 就為定制部分提供了背景信息。根據 Venkatapuram 的說法,Meta 的可擴展視頻處理器(MSVP) 是 Meta 制作 RISC 之旅的起點,正在制作中,并處理其 Facebook、Messenger 和 Instagram 服務上 100% 的所有視頻上傳。“我們之前在 CPU 上這樣做,但現在已經替換了其中的 85%,所以我們只使用了其中的 15%。”

真實的故事,應該引起處理器界注意的是,Meta 正在跳過無處不在的 GPU,并在 RISC-V 上構建 AI推理和訓練芯片。

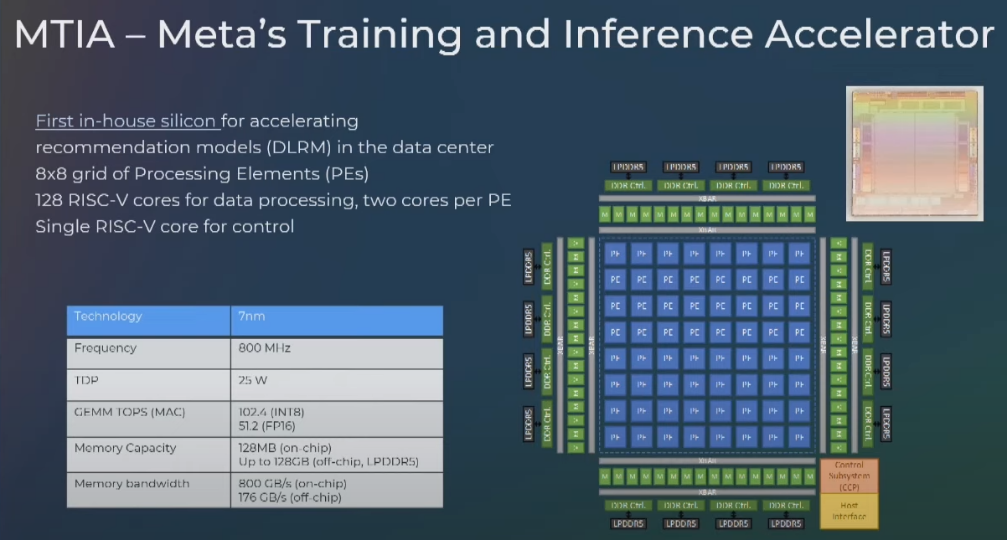

目前,RISC-V AI處理器致力于在推理和訓練中加速推薦模型。該架構對 8×8 網格的處理元素并不陌生,每個元素托管 2 個 RISC-V 內核(一個標量,一個向量)和一個用于控制的內核。標量和矢量內核與命令處理器同步,命令處理器與 Meta 開發的內置固定函數協同工作。

除此之外,我們所知不多,但我們將尋求更多答案,包括 Meta 對 RISC-V 架構的生產量。

雖然所有這些都是有希望的,但也有一些挑戰確實讓人不得不停下來,盡管它們似乎并沒有削弱Venkatapuram的樂觀情緒。

盡管進行了大規模定制,但 Meta 仍然需要從現有的 IP 選項中獲得更多。他解釋說:“很少有產品能夠將自定義指令和資源無縫集成到 RTP、模擬器、軟件工具和編譯器中。另一個挑戰是各個供應商缺乏互操作性,但他沒有提供深入的細節。歸根結底,我們感覺到挑戰并非不可克服。”

最重要的障礙之一是對矩陣擴展的支持,尤其是當 Meta 尋求在 RISC-V 上構建更多生產 AI 工作負載時。他解釋說,矩陣數學是人工智能的一個關鍵組成部分,雖然RISC-V有向量擴展,但矩陣沒有標準的擴展。他引用了這方面的工作(許多供應商,包括Stream Computing和T-HeadSemi),但最終,無論他們想出什么都應該標準化。

Venkatapuram 強調了更廣泛的生態系統支持的重要性,從對所有主要庫和工具的支持到硬件生態系統。

RISC-V由于其開放標準性質,有可能吸引更多的第三方工具、軟件、外圍設備供應商,而不僅僅是專有的ISA,但這種潛力尚未完全實現。